🐊 논문 링크: https://proceedings.neurips.cc/paper/2017/file/3f5ee243547dee91fbd053c1c4a845aa-Paper.pdf

Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., ... & Polosukhin, I. (2017). Attention is all you need. Advances in neural information processing systems, 30.

INTRO

2017년 Google Brain팀에서 발표한 ‘Attention Is All You Need’ 논문에 나온 Transformer는 BERT나 GPT의 기반이 되는 자연어 처리 분야의 핵심 모델이다. 논문 제목 그대 RNN을 사용하지 않고 Attention Mechanism만을 활용하여 시퀀스를 처리한다. Transformer를 잘 이해하기 위해서는 Seq2Seq과 Attention에 대한 선행 지식이 필요하다.

- Seq2Seq: https://arxiv.org/pdf/1409.3215.pdf

- 본 논문은 2개의 LSTM 레이어를 각각 인코더–디코더 구조로 나타낸 시퀀스 투 시퀀스 모델을 제시한다.

- 말 그대로 시퀀스 데이터를 입력 받고, 아웃풋으로 대응하는 시퀀스를 출력한다.

- 본 모델은 입력 시퀀스와 출력 시퀀스의 길이가 다를 수 있다는 점을 해결한 모델이며, 문장 번역 분야에 사용된다.

- 그러나 인코더의 마지막 hidden state만을 디코더에 전달하기 때문에 표현력이 제한된다는 단점이 존재한다.

- Attention : https://arxiv.org/pdf/1409.0473.pdf

- Seq2Seq 모델을 보완한 Attention mechanism은 디코더 매 시점마다 인코더의 모든 입력 단어들의 hidden state를 참고한다.

- Attention score를 특정 스칼라 값으로 구한 후 소프트 맥스를 통해 확률 값으로 나타낸다.

- 이러한 메커니즘으로 디코더의 각 입력이 인코더의 어떤 출력에 가장 높은 연관이 되는지 가중치를 곱연산을 통해 표현한다.

Transformer

Transformer는 Attention Mechanism만을 활용하여 RNN을 사용하지 않고 시퀀스 처리한다. RNN은 recursive한 구조이기 때문에 순차적으로 하나씩 시퀀스를 처리해야 한다. 따라서 병렬적인 연산이 어렵다는 단점이 존재한다.

Transformer는 attention만을 사용하여 병렬화 연산을 가능하게 했고, 학습 속도도 개선하였다.

Transformer의 전체적인 아키텍처이고 인코더 구조부터 하나하나 살펴보도록 하겠다.

아래 자료들은 Jay Alammar의 블로그를 참고한다. 과정을 간단하게 도식화한 그림 위주로 볼 예정이다.

https://jalammar.github.io/illustrated-transformer/

Encoder-Decoder

Transformer 역시 큰 틀에서는 Encoder–Decoder 구조를 따른다.

그러나 내부적으로 Seq2Seq과 달리 Attention 메커니즘만을 활용하여 시퀀스를 처리한다.

Transformer의 특징은 여러 겹의 Encoder–Decoder를 stack한 구조를 가지고 있다.

오리지널 페이퍼는 6개의 스택을 쌓았는데, 굳이 6개일 필요는 없다고 말한다. 그러나 인코더와 디코더 스택의 수는 같다.

또한 각 인코더의 출력은 다음 인코더의 입력이 되고, 마지막 인코더의 출력이 각 디코더에 영향을 준다.

Encoder

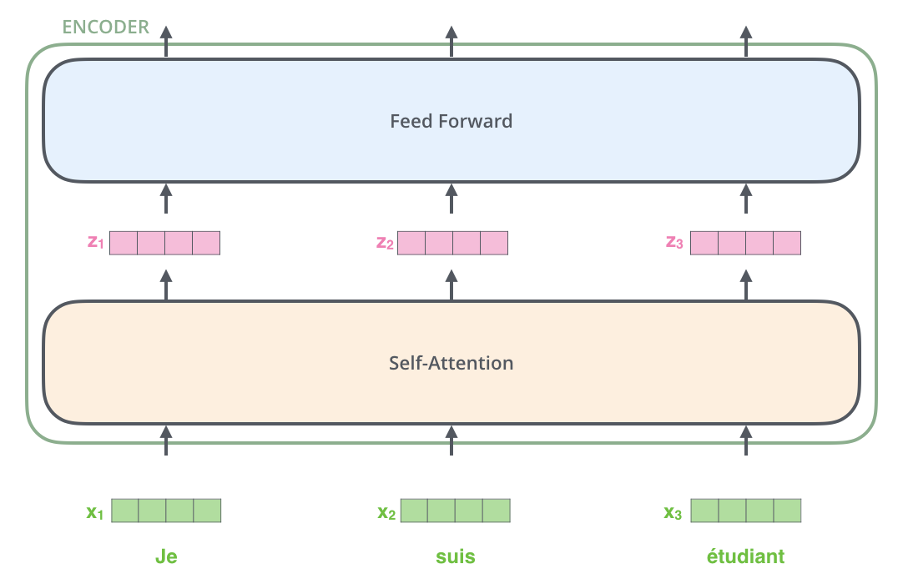

하나의 인코더는 크게 Self-Attention 레이어와 FFNN 레이어로 구성된다.

인코더에서는 입력으로 512길이의 시퀀스를 입력 받는다.

인코더 층의 Self-Attention은 RNN과 달리 입력 받은 시퀀스를 한번에 처리한다.

모델은 그림과 같이 2단계로 구성된 n개의 인코더가 stack된 구조이다.

Self-Attention 레이어는 하나의 토큰이, 다른 토큰과 얼만큼 연관이 있는지 표현하는 레이어이다.

이후 각 토큰은 FFNN 레이어를 거치는데, 토큰들이 각각 연산되기 때문에 포지션이 그대로 유지된다.

인코더의 전체 구조이다. 맨 아래 인풋 시퀀스를 처리하는 순서대로 하나씩 살펴보겠다.

1. Embeddimg

2. Positional Encoding

3. Multi-Head Attentiom

4. Add&NormFFNN

1. Embedding

인풋 시퀀스는 임베딩 레이어를 거쳐 맨 처음 인코더의 입력으로 들어간다. 우리가 흔히 아는 워드 임베딩, 글로브 등을 사용하고 임베딩 차원은 512이다. 이 임베딩은 맨 처음 인코더의 입력으로만 사용되고, 이후 인코더들은 직전 인코더의 출력을 입력으로 받는다.

2. Positional Encoding

임베딩 된 토큰들은 Positional Encoding을 거친다. Transformer의 장점은 RNN 모델을 쓰지 않지 않고, 입력 데이터를 한번에 사용하는 것이다. 따라서 단어가 가지고 있는 위치 정보를 별도로 표현할 장치가 필요하다. Positional Encoding은 각각의 인풋 임베딩에 단순히 더해지는 벡터이다.

Positional Encoding은 아래 주기함수로 표현된다.

$$ PE(pos,2i)=\sin(10000_{2i}/d_{model}pos) $$

$$ PE(pos,2i+1)=\cos(10000_{2i}/d_{model}pos) $$

Positional encoding은 두가지 목적을 달성해야 한다.

1. 두 단어의 거리가 실제로 인풋 시퀀스에서 멀어지게 되면, 둘 사이의 Positional encoding 거리도 멀어져야 한다,

2. 입력 시퀀스와 같은 크기로 표현되어야 한다.

3. Multi-Head Attention

임베딩을 거친 토큰들은 인코더의 두 개의 레이어를 지나게 된다. 논문에 따르면 각 토큰은 own path를 지나는데, 위 그림에서 이를 표현하고 있다. 주목할 점은 Self-Attention 레이어에서는 입력들 간의 dependencies가 있는 것이 특징이고, FFNN 레이어에는 각각 dependencies가 없다. 그러나 같은 인코더 블록 안에서는 가중치를 공유한다는 점이 중요하다.

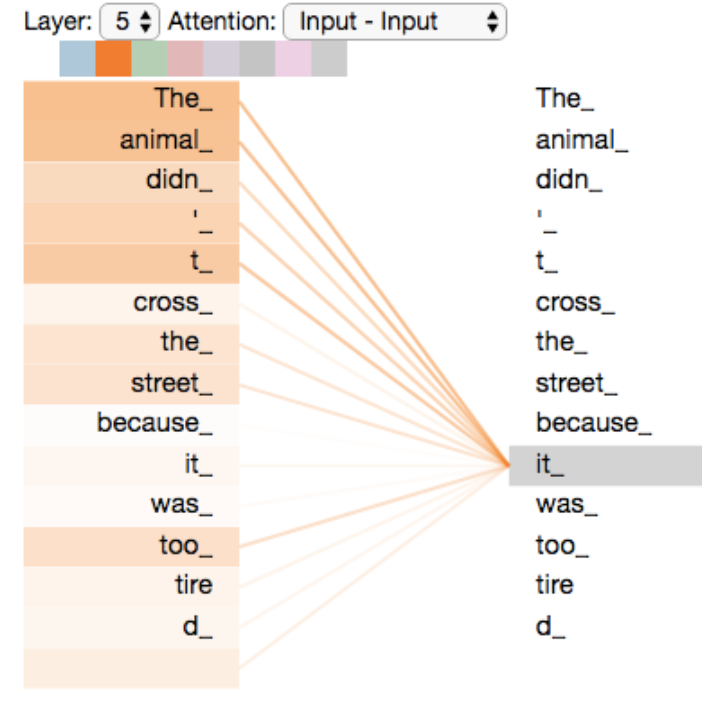

Self-attention을 개념적으로 본다면, 입력 시퀀스끼리의 위치 정보를 표현하는 것이다.

아래와 같은 문장에서 'it'이 어떤 토큰과 큰 연관성을 갖는지, 즉 어떤 의미를 갖는지 스코어화 하는 것이다.

”The animal didn't cross the street because it was too tired”

Query / Key / Value

Self-attention을 조금 더 구체적으로 살펴보겠다.

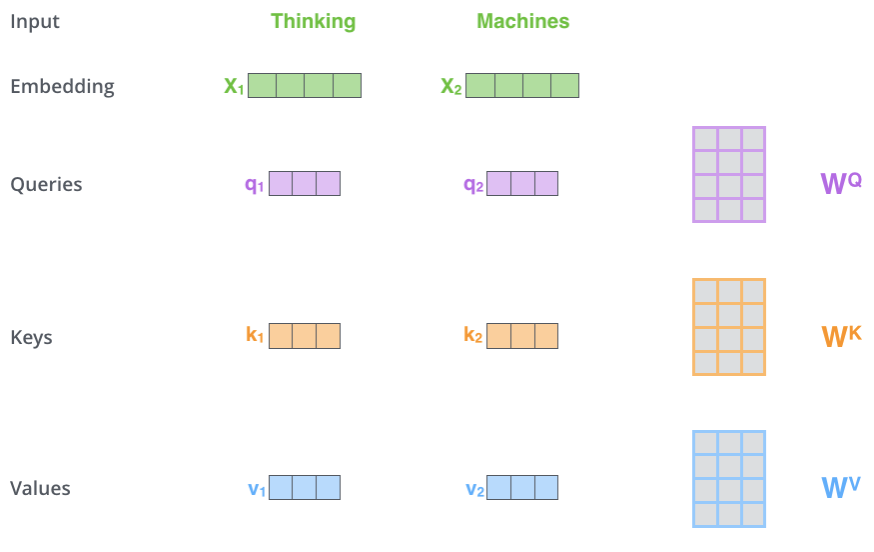

먼저 Self-attention을 하기 위해 각각의 인풋 벡터를 활용해서 3종류의 벡터를 만든다.

- Q(Query) : 현재 내가 보고 있는 단어의 representation. 다른 단어를 scoring하기 위한 기준이 되는 값.

- K(Key) : 쿼리가 주어졌을 때 relevant한 단어를 찾기 위한 아이덴티티 벡터와 같이 이해하면 된다.

마치 레이블과 같다고 표현하고, softmax score를 구하기 위해 사용한다. - V(Value) : key를 레이블로 본다면, value는 실제 값으로 볼 수 있다. 최종 값인 z를 구하기 위해 곱해지는 값이다.

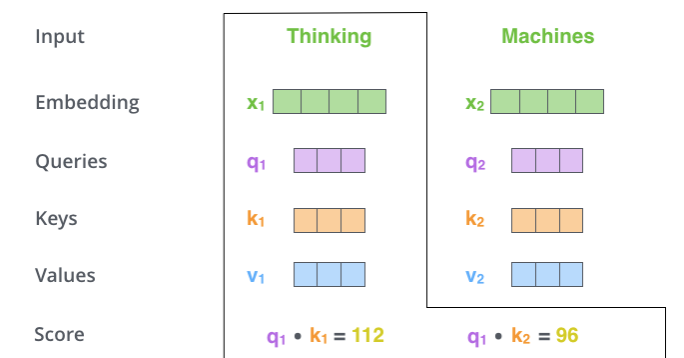

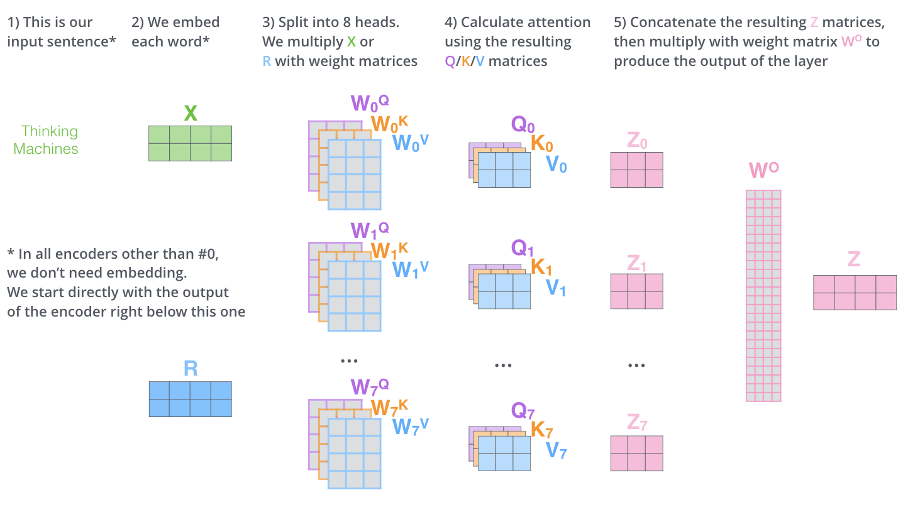

위 그림은 'Thinking' / 'Mechines' 두 토큰에 대해 q, k, v를 계산하는 과정을 도식화 한다.

모델이 학습하는 가중치는 $W^Q W^K W^V$이다

Step1

q, k, v는 각각의 인풋 임베딩으로 부터 만들어진다. 각 인풋 임베딩과 학습 대상이 되는 $W^Q, W^K, W^V$ 가중치 메트릭스 곱한다.

위 그림에서 'Thinking' 토큰은 $X_1$이라는 4차원 벡터로 표현 되었다. 이를 4x3 메트릭스 $W^Q$와 곱하면 1x3 벡터인 $q_1$을 구할 수 있다. $q_i, k_i, v_i$ 모두 동일한 방식으로 구한다.

여기서 $W^Q, W^K, W^V$의 차원은 인풋 임베딩의 차원보다는 작게 설정한다.

꼭 그럴 필요는 없지만, 이후 Multi-head embedding에서 최종 z값을 concat을 하기에 효율적이다.

Step2

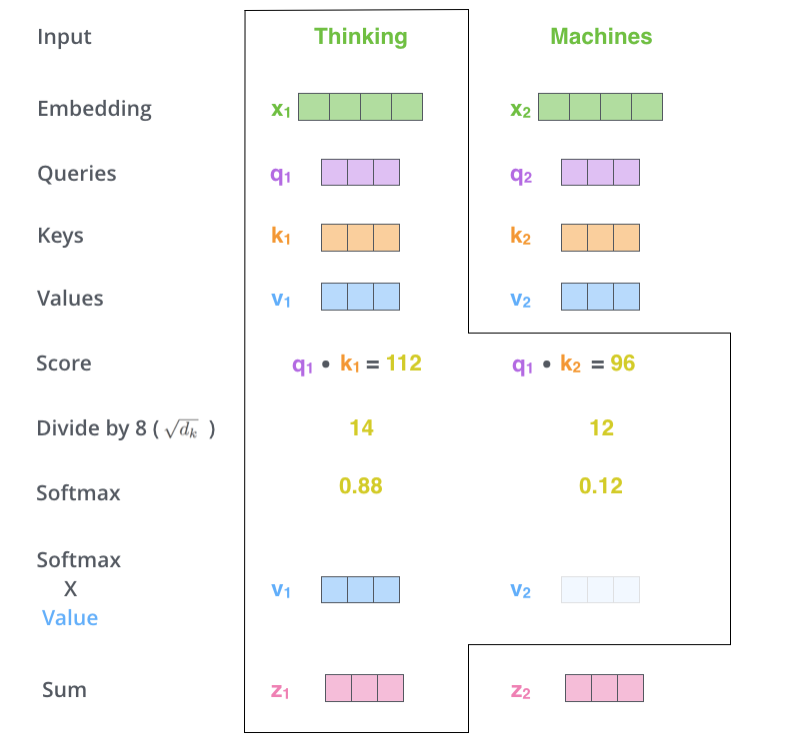

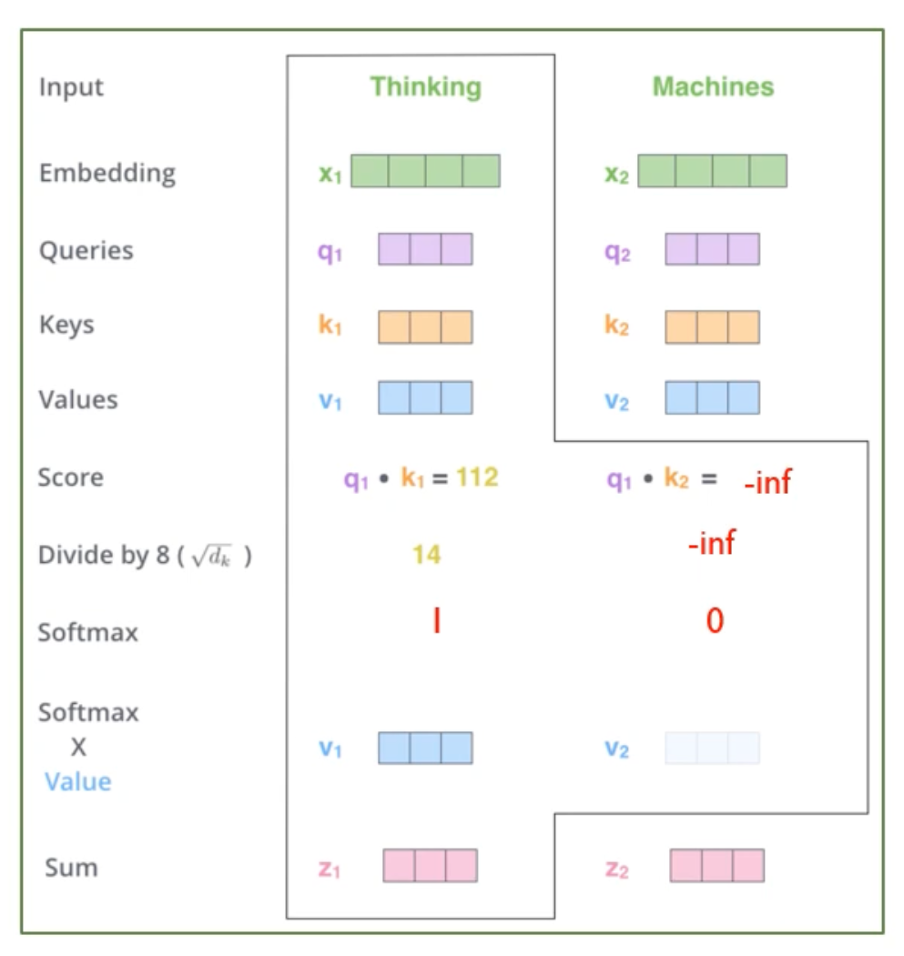

앞서 예시와 같이 우리가 관심있는 ‘it’ 단어의 쿼리와 가장 관련성이 높은 단어를 찾기 위해 score를 계산하여 확률 값으로 나타낸다.

현재 보고 있는 토큰의 쿼리와, 나를 포함한 나머지 토큰들의 key들을 곱해준다. 이 값은 스칼라로 표현되고 이 값을 임베딩 차원의 루트 쓰운 값으로 나누어서 softmax를 적용한다. 이 스코어는 각 단어가 내가 보고 있는 쿼리의 단어와 얼마나 관련이 있는지 나타내는 정도를 표현한다.

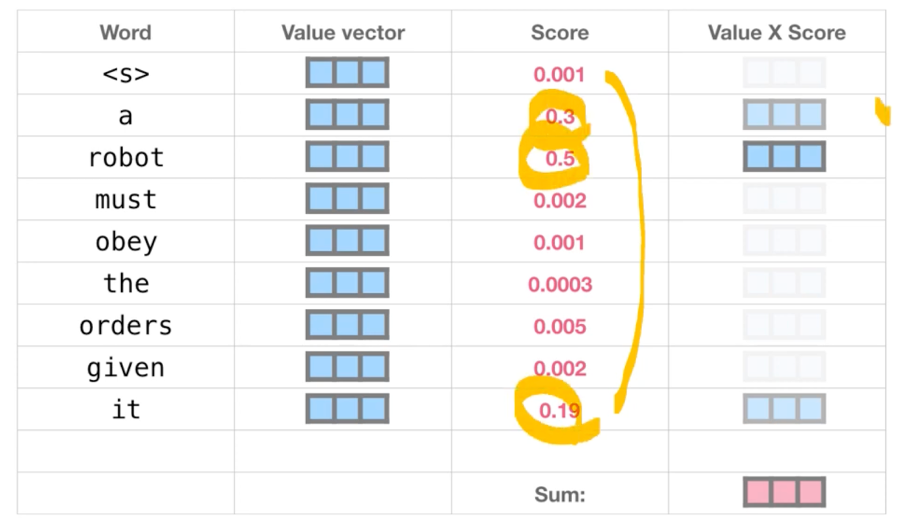

이렇게 쿼리와 키를 통해 관련성 스코어를 구하고, 이 softmax score와 실제 value 값을 곱한다. 이는 단어의 중요도에 따라 Weight를 준 것과 같다. 위 그림은 v1, v2의 투명도로 중요도를 표현힌다. 최종적으로 모든 단어에 대한 v를 더하면 Thinking의 self-attention layer 아웃풋이 된다. 위 그림은 모든 단어에 대한 softmax 스코어를 구한 후 Weighted sum을 하여 최종 z 값을 구하는 그림이다.

위 표는 모든 토큰에 대해 softmax 스코어를 구한 과정을 보여준다.

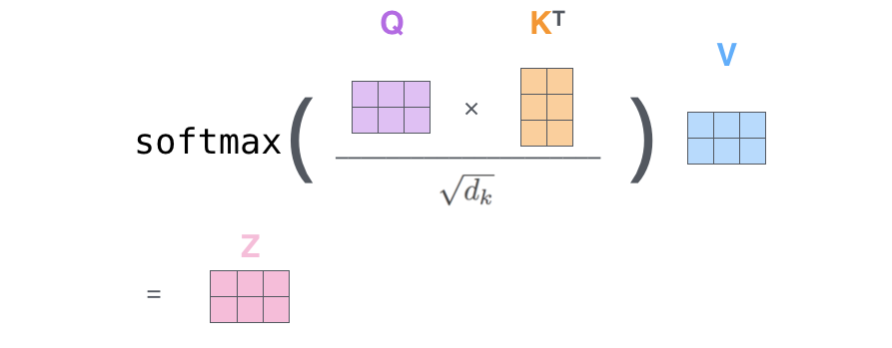

위 과정을 최종적으로 간단히 표현하면 위의 그림과 같다. 최종 z값의 차원은 각 q,k,v 차원과 같다는 점이 중요하다.

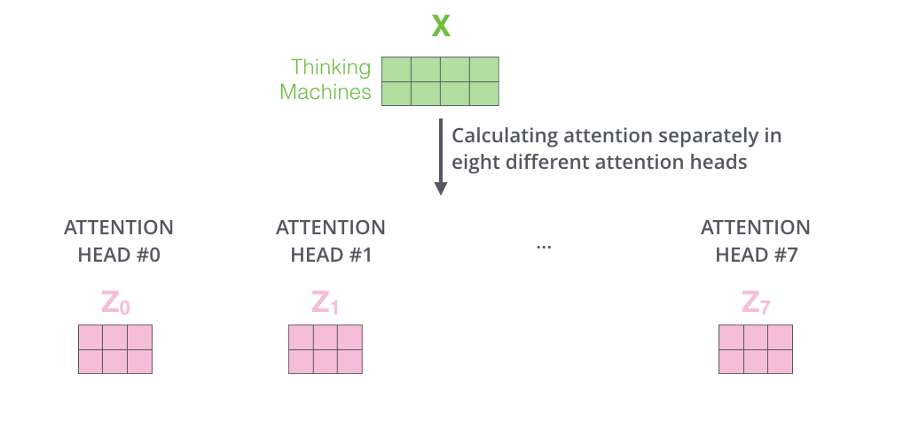

Multi-head attention

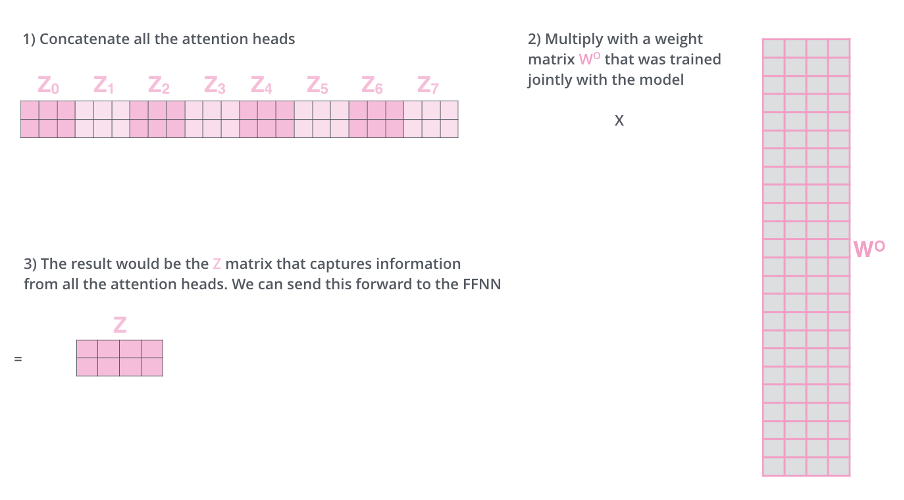

지금까지는 single attention에서 z값을 구하는 과정을 설명했다, Multi-head attention은 각 single attention을 각각 계산한 후 이를 통합하는 기법이다. 논문에서는 8개의 single attention 각각 따로 계산한다. Multi-head attention을 사용하는 이유는 ‘it’이라는 단어가 문장 내에서 하나의 관계만을 갖지 않고 여러 경우의 수가 있기 때문에 이를 표현한 것이다. 여러 개의 Attention Head를 계산한 후 최종적으로 계산된 Z값들을 concat 한다.

마지막으로 각 Attention Head의 Z값을 concat벡터를, 가중치인 $W^Q$에 곱해서 인풋 차원과 동일한 디멘전을 갖도록 만든다. $W^O$는 모델의 학습 대상이 되는 값이다. 최종 Multi-Head Self-Attention 단계의 그림은 아래와 같다.

The Residuals & FFNN

지금까지 인풋 토큰에 대해서 임베딩을 하고, Positional encoding과 더한 후에 Self-Attention을 하는 과정을 보았다.

Add & Norm 층은 간단하다. Residual을 그대로 더해주고 layer normalization을 진행한다. Residual은 ResNet처럼 input 자기 자신을 더해주면 된다. 이렇게 해서 FFNN에 입력으로 들어가게 될 z1, z2..zi 값이 만들어 진다.

각 토큰의 z값은 독립적으로 FFNN층으로 들어가고 fully connected 연산을 진행한다. 식은 아래와 같다.

$$FFN(x) = max(0, xW_1 + b_1)W_2 + b_2 $$

max(0, x)는 RuLU 함수를 의미한다. 각 z1, z2은 독립적으로 FFNN을 진행하지만, 하나의 인코더 블락 내에서 가중치는 공유한다.

Decoder

Masked Multi-Head-Attention

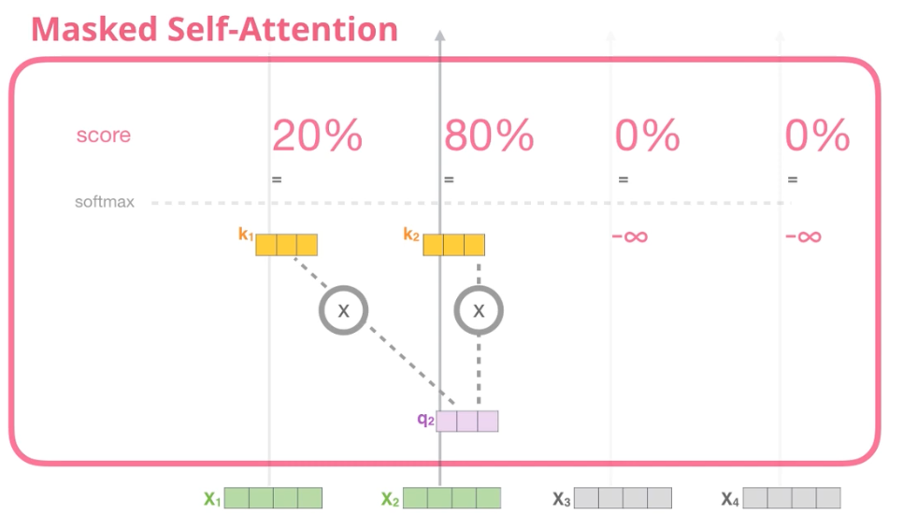

모든 인풋을 한번에 처리하는 인코더와 달리, 디코더는 반드시 자기 자신보다 앞쪽에 해당하는 토큰만을 고려할 수 있다. 이를 수학적으로 표현하면, 뒤 토큰들을 -inf로 강제해서 softmax score가 0이 되도록 만드는 기법을 사용한다.

아래 그림은 attention의 softmax score를 구하는 과정에서 masking을 적용한 것을 직관적으로 보여준다.

Multi-Head-Attention with Encoder Outputs

인코더의 아웃풋과 디코더가 상호작용하는 부분이다.

마지막 인코더의 출력은 모든 디코더의 Multi-Head-Attention with Encoder Ouputs 층과 상호작용을 한다. 이때 attention vector인 K와 V가 사용된다. Masked self attention층을 지난 디코더의 인풋은 인코더의 K, V 값과 다시 Multi-head attention 과정을 거친다.

디코더는 각 인풋에 대해서 연산을 시퀀셜하게 처리한다는 점이 인코더와 다른 부분이다.

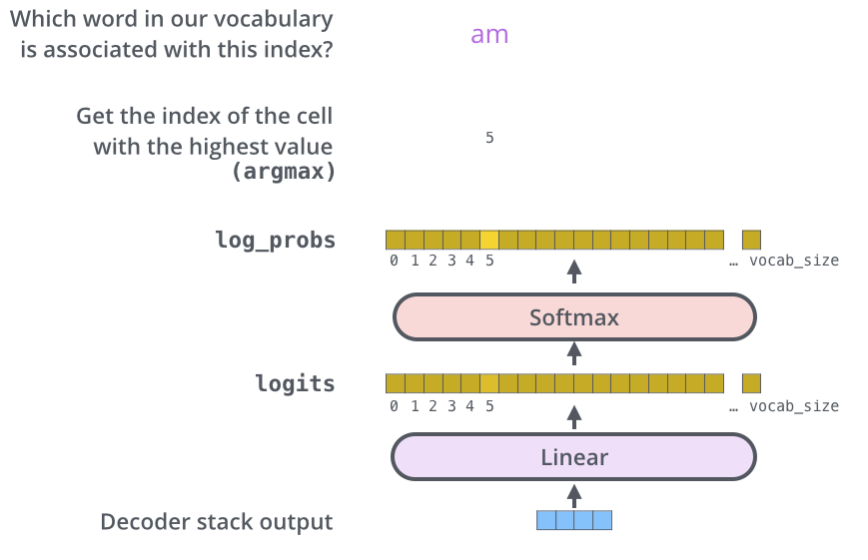

Final Linear Layer

마지막으로 디코더의 stack output은 fc층과 소프트 맥스 층을 지나, vocab_size만큼의 결과를 도출한다.

Final linear layer는 단순 완전연결층이다.

이렇게 Transfomer의 임베딩부터 Fc 층까지 차례대로 살펴 보았다.

이제는 model architecture가 조금은 친숙하게 보일 것이다.

'DL' 카테고리의 다른 글

| [DL] Gradient descent algorithm (0) | 2022.07.21 |

|---|